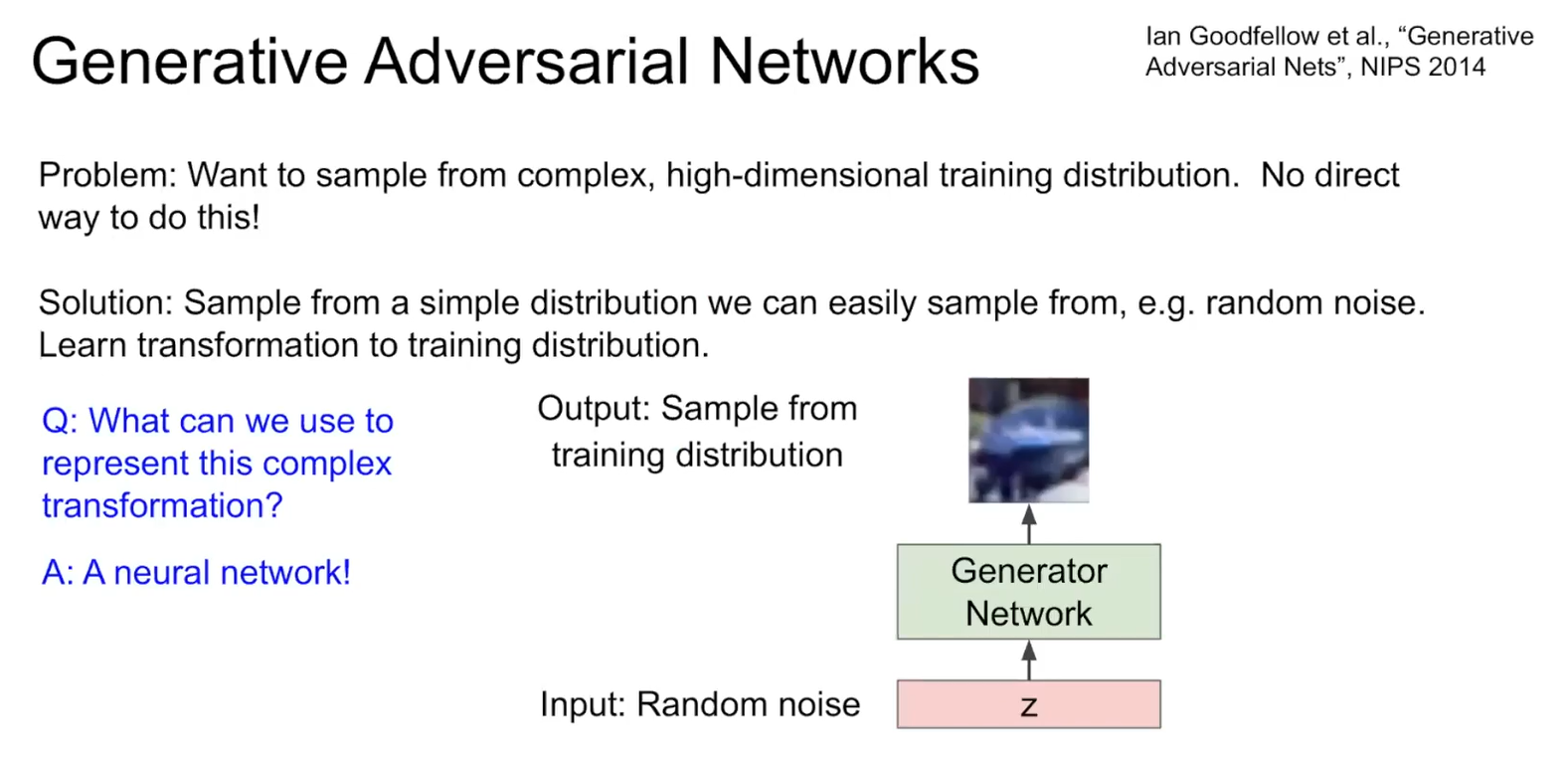

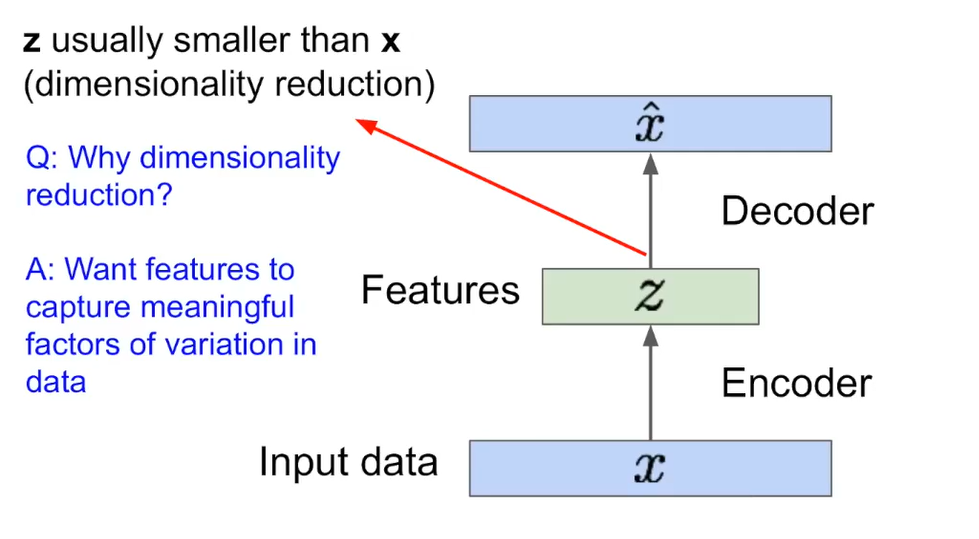

Generative Adversarial Networks GAN : generative model중에 크게 VAE와 GAN이 있는데 GAN이 압도적으로 더 많다. GAN 중 일부는 VAE의 좋은 특성을 갖고 있는 것들도 있다. GAN이란, generator(생성자)와 discriminator(판별자) 네트워크 간의 경쟁적인 학습을 기반으로 하며, 실제 데이터와 비슷한 가짜 데이터를 생성하는 모델이다. generator는 random latent vector(잠재 벡터) 에서 데이터를 생성하려 계속해서 업그레이드 되고, discriminator는 생성된 데이터와 실제 데이터를 구별하기 위해 계속해서 업그레이드 됨으로써 이 둘이 경쟁 구도를 가지며 생성자가 점차적으로 실제와 더욱 유사한 데이터를 생성하도록 ..