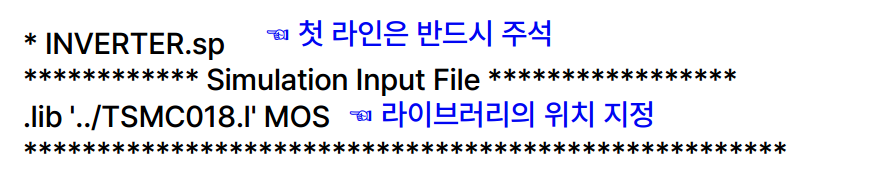

SPICE (inverter) SPICE 파일 (.sp) 만들기 [Simulation input file] - 첫 라인은 반드시 주석으로 작성한다. - 라이브러리의 위치 지정 필요 [Condition] - option scale : spice simulation에서 사용할 길이 단위 - global VDD GND : 전역 노드로 'VDD'와 'GND'를 정의한다. 회로에서 전원 공급 및 전압을 나타내는 노드로 사용 - temp : 시뮬레이션을 위한 온도를 설정한다. 섭씨 기준으로 작성된다. [Input Signal] -input signal 입력 순서 : 입력신호이름 -> IN -> OUT -> IN과 OUT 사이 전압 Vdd VDD GND 3.3 //Vdd라는 input 전원 source 생성, VDD..