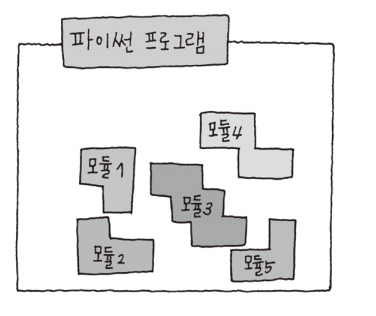

05-2 모듈 모듈 (module) 모듈이랑 함수나 변수 또는 클래스의 정의를 담고 있는 단일 파일이다. 모듈은 코드의 재사용과 구조화를 돕는데 사용된다. 모듈은 다른 파이썬 프로그램에서 불러와 사용할 수 있게끔 만든 파이썬 파일이라고도 할 수 있다. add,sub 함수가 있는 mod1.py를 만들고, C:\doit 디렉토리에 저장하면, mod1.py파일이 바로 모듈이다. (파이썬 확장자 .py로 만든 파이썬 파일은 모두 모듈이다.) 모듈 생성 및 사용 - 모듈 생성 : 파이썬 스크립트 파일을 만들고, 그 파일 내에서 변수,함수,클래스 등을 정의한다. 이 파일의 확장자는 '.py'여야한다. 예를 들어 "my_module.py"라는 파일을 만들고 그 안에 함수를 정의할 수 있다. - 모듈 사용 : 다른 파..